Огляд Jan AI: Локальна альтернатива ChatGPT

Ваш персональний ChatGPT, який працює 100% офлайн.

Jan AI — це Open Source платформа, яка перетворює ваш комп’ютер на локальний сервер штучного інтелекту. Головна особливість — повна сумісність з OpenAI API, що дозволяє використовувати локальні моделі в будь-яких додатках, які раніше вимагали платних ключів від ChatGPT. На відміну від хмарних сервісів, Jan зберігає всі дані та процеси на вашому пристрої.

Чому варто обрати Jan AI

- Повна приватність: Ваші промпти та дані ніколи не залишають ваш комп’ютер.

- Гнучкість моделей: В один клік встановлюйте Llama 3, Mistral, Gemma або підключайтеся до віддалених API (OpenAI, Claude).

- OpenAI-сумісність: Вбудований локальний сервер дозволяє використовувати Jan як заміну платному API в інших додатках.

- Open Source: Вона безкоштовна та прозора.

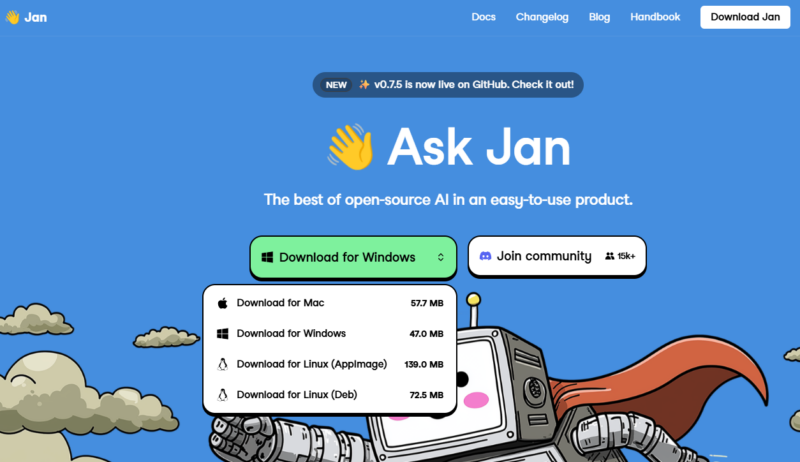

Технічні вимоги: Працює на Windows, macOS (включаючи процесори M1/M2/M3) та Linux. Для стабільної роботи локальних моделей (інференсу) критично важливі ресурси вашого заліза:

| Компонент | Мінімальні вимоги | Рекомендовано (для моделей 13B+) |

| CPU | 4 ядра (з підтримкою AVX2) | 8+ ядер |

| RAM | 8 GB | 32 GB і вище |

| GPU | Не обов’язково | NVIDIA (8GB+ VRAM) / Apple M-series |

| Диск | 20 GB (SSD) | 100 GB+ (під бібліотеку моделей) |

Ключові сценарії використання

- Локальний RAG (Base Knowledge): Інтеграція з вашими PDF, документами та базами даних через векторні індекси (Chroma/FAISS).

- Розробка та тести: Використання локального ендпоінту

http://localhost:1337для відлагодження коду без витрат на API хмарних провайдерів. - Приватний асистент: Налаштування персональних ролей (Кодер, Аналітик, Редактор) зі збереженням історії листування на диску.

Чи потрібен інтернет для роботи Jan?

Тільки для завантаження моделей. Після цього ви можете спілкуватися з ШІ в повністю автономному режимі.

Чи це платна програма?

Ні, Jan повністю безкоштовна і розповсюджується під ліцензією Apache 2.0.

Чи можна використовувати Jan AI як заміну платному API OpenAI?

Так. Jan запускає локальний сервер, який повністю імітує структуру запитів OpenAI. Ви можете просто змінити base_url у своєму додатку на локальний, і він почне працювати з моделями Llama, Mistral або Gemma.

Які формати моделей підтримує Jan?

Jan працює з більшістю сучасних форматів, включаючи GGUF (оптимально для CPU), TensorRT та інші квантовані версії, які значно прискорюють роботу на домашньому залізі.

Чи потрібно встановлювати додаткові драйвери?

Для користувачів Windows/Linux рекомендується встановлення драйверів NVIDIA CUDA або бібліотек ROCm (для AMD), щоб задіяти відеокарту. На macOS (процесори M1/M2/M3) все працює «з коробки» завдяки підтримці Metal.