Я давно експериментую з локальними моделями та нещодавно спробував Jan AI. Мені сподобалася ідея: запускати потужний ІІ прямо на своєму комп’ютері без інтернету. Це дає контроль над даними та свободу в налаштуванні. Далі розповім, що це таке і навіщо взагалі може стати в нагоді.

Jan AI: що це і навіщо використовувати локальний ШІ без інтернету

Для мене jan ai — це інструмент, який перетворює локальну машину на невелику AI-платформу. Він зазвичай надає сумісний з OpenAI API інтерфейс. Це означає, що багато програм і скриптів, які звикли працювати з хмарою, можна перенаправити на локальний сервер без великих переробок. Я бачу в цьому сенс, коли не хочеться відправляти конфіденційні дані в хмару. Ще це корисно в місцях зі слабким інтернетом або коли потрібна детермінована відповідь без зовнішніх оновлень моделі.

Навіщо використовувати локально? Я перелічу основні причини, які особисто для мене зіграли роль:

- Конфіденційність: дані залишаються у мене.

- Передбачуваність: поведінка моделі стабільна, поки я не оновлю її.

- Інтеграція з локальними даними: швидко шукати по власних архівах і базах.

- Економія на хмарних запитах при частому використанні.

При цьому jan ai часто служить мостом між моделями, які ви завантажите, і програмами, які їх використовують. Це зручно, коли хочеться швидко прототипувати асистента або автоматизацію, не прив’язуючись до зовнішніх провайдерів.

Переваги та обмеження jan ai при роботі без інтернету

Я відразу кажу про плюси і мінуси, тому що важливо розуміти компроміси. Локальний ai дає свободу, але вимагає ресурсів і турботи про безпеку.

| Переваги | Обмеження |

|---|---|

| Повний контроль над даними та конфігурацією | Потрібні CPU/GPU і достатньо місця для моделей |

| Немає залежності від зовнішнього інтернету | Немає автоматичних оновлень знань моделі |

| Можливість кастомізації та інтеграції з локальними системами | Потрібне адміністрування та резервне копіювання |

Мені допомогла така звичка: спочатку оцінити завдання і тільки потім переносити їх офлайн. Якщо завдання — генерація тексту і робота з локальною базою, локальний режим ідеальний. Якщо потрібна найсвіжіша світова інформація, хмарні сервіси все ще виграють.

Порада: якщо важлива актуальність знань, комбінуйте локальну модель з періодичним оновленням даних з безпечних джерел.

Ще відзначу технічні обмеження. Для великих моделей потрібна хороша відеокарта і багато RAM. На слабких машинах доведеться використовувати менші або квантовані версії моделі. В інших випадках ви зіткнетеся із затримками при інференсі та можливими несумісностями зі старими програмами.

Як користуватися jan ai офлайн: перший запуск і базові сценарії

Я зазвичай починаю з підготовки. Якщо ви задумалися, як користуватися jan ai, то порядок такий: підготувати систему, завантажити модель, запустити сервер і підключитися через API. Все просто, якщо розбити на кроки.

- Перевіряю системні вимоги і звільняю місце під модель.

- Завантажую потрібну модель і розгортаю її в окрему папку.

- Запускаю jan ai-сервер і перевіряю health endpoint.

- Підключаюся через curl або вже знайому бібліотеку, змінюю endpoint на локальний.

Типові сценарії, які я використовую:

| Сценарій | Приклад |

|---|---|

| Генерація текстів | curl до локального /v1/chat/completions |

| Локальний асистент | Інтеграція з GUI або CLI, читання локальних файлів |

| Пошук по базі знань | Векторні індекси та запити до моделі для ранжування |

Прямий лайфхак: для швидкого тесту використовуйте зменшену модель. Так ви перевірите інтеграцію без довгого очікування і великої витрати ресурсів.

Загалом, як користуватися — вирішувати вам. Я віддаю перевагу почати з простих завдань. Потім додаю автоматизацію та інтеграції. Такий підхід економить час і нервові клітини.

Системні вимоги та підготовка обладнання

Я завжди починаю з перевірки заліза. jan — локальний ШІ. Він любить швидкі диски і багато оперативки. Для базових моделей підійде звичайний ноутбук. Для серйозної роботи з великими моделями потрібен GPU. Нижче я розписав орієнтири, щоб тобі було легше зорієнтуватися.

| Компонент | Мінімум | Рекомендовано |

|---|---|---|

| CPU | 4 ядра | 6+ ядер, сучасні інструкції (AVX/AVX2) |

| RAM | 8 GB | 32+ GB |

| GPU (якщо потрібен) | не обов’язково | NVIDIA 8GB+ або еквівалент з підтримкою CUDA/ROCm |

| Диск | 20 GB вільного | SSD, 100+ GB (моделі та кеш) |

| ОС | Linux/macOS/Windows 10+ | Linux (Ubuntu) для максимальної гнучкості |

Перед встановленням перевір драйвери GPU. На Linux це NVIDIA драйвери і CUDA або ROCm для AMD. На macOS переконайся, що Homebrew встановлений. На Windows корисні WSL2 і драйвери CUDA. Я також рекомендую виділити окремий диск або розділ для моделей. Вони займають місце швидко.

Порада: онови систему і встанови Python 3.10+. Це економить час при встановленні залежностей.

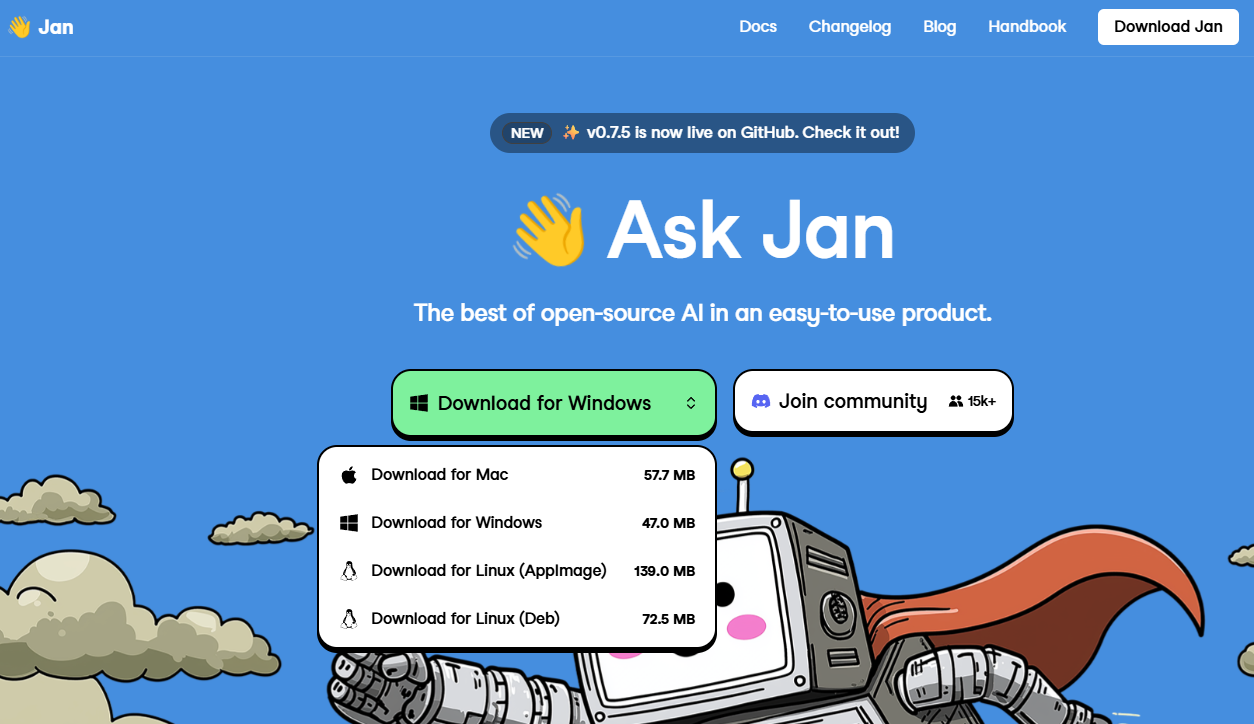

Покрокове встановлення та запуск (Linux, macOS, Windows, Docker)

Я опишу просту послідовність для кожної платформи. Слідуй крокам і перевіряй вивід команд. Якщо десь зупинилося — повернись до попереднього кроку.

Linux (Ubuntu)

- Оновлюй систему:

sudo apt update && sudo apt upgrade -y

- Встановлюй залежності:

sudo apt install -y python3 python3-venv python3-pip git build-essential

- Налаштуй драйвери GPU (при наявності NVIDIA):

sudo apt install -y nvidia-driver-### cuda-toolkit-###

- Клонуй jan і створи віртуальне оточення:

git clone https://github.com/.../jan.git

cd jan

python3 -m venv venv

source venv/bin/activate

pip install -r requirements.txt - Запускай локальний сервер:

python run_server.py --port 8080

macOS

- Встановлюй Homebrew, якщо немає:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

- Встанови Python і Git:

brew install python git

- Далі як на Linux: клонуй проект, створи venv і встанови залежності.

- На Apple Silicon перевір сумісність моделей і використовувані бінарники.

Windows (WSL2 бажано)

- Увімкни WSL2 і встанови Ubuntu з Microsoft Store.

- Слідуй інструкціям для Linux всередині WSL.

- Якщо запускаєш нативно в Windows, встанови Python і Git, потім виконуй ті ж кроки в CMD/PowerShell.

Docker

Docker зручний для ізоляції та швидкого розгортання. Я зазвичай так роблю:

- Встанови Docker і Docker Compose.

- Створи файл docker-compose.yml або використай готовий з репозиторію jan.

- Запускай:

docker-compose up -d --build

- Перевіряй логи:

docker-compose logs -f

Docker корисний, якщо хочеш однакове середовище на різних машинах. Мінус — потрібні ресурси і налаштування GPU passthrough.

Як користуватися: робота з OpenAI-сумісним локальним API

Я кажу простими словами. jan надає API, схоже на OpenAI. Це зручно. Зберігаєш звичні скрипти. Змінюються тільки адреса і ключі.

Типовий базовий запит curl виглядає так:

curl http://localhost:8080/v1/chat/completions

-H "Authorization: Bearer local-secret"

-H "Content-Type: application/json"

-d '{"model":"gpt-j","messages":[{"role":"user","content":"Привіт, як справи?"}]}'

В Python все ще простіше:

import requests

resp = requests.post(

"http://localhost:8080/v1/chat/completions",

headers={"Authorization":"Bearer local-secret"},

json={"model":"gpt-j","messages":[{"role":"user","content":"Привіт"}]}

)

print(resp.json())

Поради щодо використання:

- Зберігай ключ у змінній середовища: JAN_API_KEY. Не пиши його в коді.

- Перевіряй доступність: GET /v1/models поверне список доступних моделей.

- Для стримінгу використовуй SSE або WebSocket, якщо jan це підтримує.

- Обмеж одночасні запити. Локальна машина легко перевантажується.

Приклад: встанови в коді таймаути і повторні спроби. Це врятує від зависань при довгому інференсі.

Для інтеграції з існуючим кодом достатньо змінити URL і ключ. Інші частини запиту залишаються сумісними з OpenAI. Я завжди тестую спочатку простим запитом, потім додаю промпти і логіку.

Вибір, завантаження та керування моделями для jan ai

Я підходжу до вибору моделі прагматично. Спочатку вирішую, що мені важливіше: швидкість чи якість. Малі моделі працюють швидко і не вимагають багато пам’яті. Великі дають точніші відповіді, але повільніше і займають місце. Я дивлюся на формат моделі: ggml, FP16, GPTQ — від цього залежить, як її запустити локально. Завантажую тільки з перевірених джерел: офіційні репозиторії, Hugging Face або перевірені форки. Завжди перевіряю розмір і контрольну суму файлу перед встановленням.

| Тип моделі | Плюси | Мінуси |

|---|---|---|

| Малі (LLaMA-7B і подібні) | Швидко, мало ресурсів | Менше точності |

| Середні (13B—30B) | Баланс швидкості та якості | Вимагають більше пам’яті |

| Великі (70B+) | Найкраща якість | Потрібні GPU/багато RAM |

Перед завантаженням перевіряю вільне місце і пропускну здатність диска. Я завжди зберігаю метадані поруч з моделлю: версію, джерело і дату завантаження. Це допомагає керувати кількома моделями і швидко перемикатися між ними.

Порада: називайте файли моделей за шаблоном виду model-name_version_quant.bin. Так легше автоматизувати оновлення і відкат.

Квантування, оптимізація та прискорення інференсу

Квантування скорочує розмір моделі і прискорює інференс. Я частіше використовую 4-bit і 8-bit квантування залежно від завдання. 8-bit дає хороший баланс швидкості та якості. 4-bit сильніше зменшує пам’ять, але іноді псує точність. Для квантування застосовую інструменти на кшталт GPTQ або бібліотеки, вбудовані в екосистему jan ai/llama.cpp.

| Квантування | Пам’ять | Якість |

|---|---|---|

| FP16 | Середня | Висока |

| 8-bit | Низька | Добра |

| 4-bit | Дуже низька | Середня |

Оптимізації, які я застосовую: вмикаю багатопотоковість, підбираю число потоків за ядрами CPU, використовую mmap для завантаження моделей і вимикаю непотрібні логери. На CPU дивлюся наявність інструкцій AVX/AVX2/AVX512 — це прискорює матричні операції. На GPU важливо вибрати сумісний драйвер і CUDA-сумісну збірку. Тестую швидкість з різними параметрами batch і context size, щоб знайти найкращий компроміс.

Оновлення, заміна та резервне копіювання моделей

Я оновлюю моделі обережно. Ніколи не перезаписую робочу модель у продакшені. Створюю окрему папку для нової версії і проганяю тести локально. Порівнюю контрольні суми і результати на контрольних промптах. Якщо все ок, роблю перемикання через символічне посилання або переміщення в місце, де очікує jan ai. Основні кроки, які я виконую: – Зберігаю поточну модель в архів з датою. – Завантажую нову модель в тестову папку. – Проганяю швидкий тест по набору промптів. – Якщо результати допустимі, змінюю посилання на модель. Я зберігаю резервні копії як локально, так і поза машиною — на NAS або в хмарному сховищі. Налаштовую автоматичні бекапи раз на тиждень і перевіряю цілісність архіву. Для критичних систем використовую версіонування і журнал змін, щоб можна було швидко відкотитися до попередньої версії.

Налаштування персональних асистентів і промпт-дизайн (як користуватися для завдань)

Я люблю робити персональних асистентів під конкретні завдання. Спочатку задаю системне повідомлення: роль, тон і обмеження. Потім додаю шаблони промптів для повторюваних завдань. Так виходить стабільна поведінка. Я часто створюю кілька профілів: “резюме”, “кодер”, “помічник з листів”. Перемикаю профіль залежно від завдання. Список ключових принципів, які я використовую: – Чітко вказую роль і формат відповіді. – Ділю завдання на кроки і даю приклад очікуваного результату. – Обмежую довжину і стиль, якщо потрібно. – Пробую різні температури і max_tokens для балансу креативності і точності. Приклад простого шаблону промпту:

Роль: експерт з документації. Завдання: скоротити текст до 30% без втрати змісту. Вихід: пунктовий список, 5—7 пунктів.

Для складних сценаріїв я будую ланцюжки промптів. Перший промпт аналізує дані. Другий генерує чернетку. Третій робить перевірку якості. В jan ai це налаштовується як послідовність запитів до локального API. Так я досягаю надійності і передбачуваності. Для автоматизації часто зберігаю шаблони в YAML або JSON, щоб можна було швидко підставляти змінні і запускати зі скрипту.

Створення ланцюжків промптів та інструментів (tooling)

Я зазвичай будую ланцюжки промптів як набір маленьких кроків. Кожен крок вирішує просте завдання. Потім я з’єдную їх у послідовність. Це простіше відлагоджувати. Це простіше покращувати.

Типовий ланцюжок виглядає так: отримання контексту, пошук по базі знань, генерація чернетки, перевірка фактів, форматування виходу. Я використовую мінімальні промпти для кожного кроку. Так модель не втрачає фокус. Якщо щось йде не так, я змінюю тільки один крок.

Ось основні патерни, які я застосовую:

- Ретривер + генератор: спочатку схожі документи, потім RAG-генерація.

- Розділення ролей: один промпт виступає як “експерт”, інший як “редактор”.

- Контроль якості: окремий промпт для перевірки фактів і стилю.

- Функціональні виклики: промпти викликають локальні утиліти (читання файлу, пошук по векторному індексу).

Інструменти (tooling) я групую в таблицю. Так видно, що за що відповідає.

| Інструмент | Призначення | Чому локально |

|---|---|---|

| Ретривер (FAISS/Chroma) | Пошук релевантних уривків | Швидка видача, приватність |

| Промпт-шаблонізатор | Керує змінними в промпті | Спрощує тестування |

| Перевірник фактів | Звіряє вивід з локальною БД | Уникнення вигадок |

| Файлові адаптери | Читають локальні документи | Робота без інтернету |

Порада: тримайте промпти короткими і документуйте входи/виходи кожного кроку. Це сильно економить час при відлагодженні.

Я завжди тестую ланцюжок на простих сценаріях. Потім ускладнюю. Багато проблем йде на ранніх тестах. Для повторюваності я зберігаю промпти і версії моделей. Так можна відкотитися, якщо результат погіршився.

Інтеграції та автоматизація: приклади використання jan ai без інтернету

Я підключаю jan ai до локальних сервісів. Так створюю корисні автоматизації. Приклади прості, зрозумілі і реальні. Вони працюють в офлайні і захищають дані.

Ось загальні сценарії:

- Помічник з документації, який відповідає на питання команди, читаючи внутрішні файли.

- Автоматичне створення звітів з логів і CSV.

- Інтеграція з локальною CRM для підготовки шаблонів листів.

- Автономні аналітичні пайплайни: витяг, сумаризація, сповіщення.

Інтеграція з локальними базами знань і векторними індексами

Я зберігаю знання локально. Найчастіше це набір документів, PDF і база даних. Спочатку я розбиваю документи на шматки. Потім генерую ембедінги з локальною моделлю. Ці ембедінги зберігаю у векторному індексі.

Використовую FAISS або Chroma. Обидва працюють офлайн. FAISS добрий для швидкості. Chroma простіше інтегрувати. Для великих проектів беру Milvus або локальний Weaviate.

Процес зазвичай такий:

- Завантаження документів та їх нормалізація.

- Чанкінг: розбиття на логічні уривки.

- Генерація ембедінгів локально.

- Індексування в FAISS/Chroma.

- При запиті — пошук схожих уривків і додавання в промпт.

Нижче коротка таблиця з плюсами і мінусами індексів.

| Індекс | Плюси | Мінуси |

|---|---|---|

| FAISS | Дуже швидко, компактний | Менше зручностей для метаданих |

| Chroma | Простий API, сховище метаданих | Може бути повільніше на великих обсягах |

| Milvus/Weaviate | Масштабованість, інтерфейси | Складніше в налаштуванні локально |

Важливо: ембедінги генерувати тією ж моделлю, яку ви використовуєте для пошуку, інакше схожість буде поганою.

Автоматизація робочих процесів: скрипти, cron, вебхуки та тригери

Я автоматизую рутинні завдання простими скриптами. Найчастіше це Python або Bash. Скрипти викликають локальний API jan ai. Далі дані обробляються та зберігаються.

Способи тригерів:

- cron/systemd timers — для регулярних завдань: звіти, бекапи, індексація.

- inotify/file watchers — реагують на появу нових файлів.

- локальні вебхуки — сервіси в LAN можуть надсилати сповіщення на jan ai.

- скриптові ланцюжки — один скрипт запускає інший за результатом.

Приклад сценарію: скрипт сканує папку з логами раз на годину, витягує ключові події, надсилає їх в jan ai для сумаризації, а потім кладе результат у папку звітів. Все працює без інтернету. Можна додати відправку сповіщення в месенджер всередині локальної мережі.

Нижче таблиця тригерів та типових завдань.

| Тригер | Завдання |

|---|---|

| cron | Щоденні зведення, індексація нових документів |

| inotify | Обробка завантажених файлів, автоматична генерація метаданих |

| локальний webhook | Реакція на дії в інших системах LAN |

| systemd | Довгоживучі демони та спостерігачі |

Часто перевіряю логи та тримаю просту систему сповіщень. Це рятує від тихих збоїв та допомагає вчасно реагувати.

Якщо потрібно, можу надіслати шаблони скриптів та приклади конфігурацій cron/systemd. Вони у мене вже перевірені в кількох проектах.

Безпека, управління доступом та конфіденційність даних

Я вважаю, що локальний ШІ — це не лише автономність. Це ще шанс взяти контроль над своїми даними. Коли jan ai працює у вашій мережі, я роблю ставку на кілька простих принципів. Перший — мінімум прав для сервісів. Другий — розділення мереж та сервісів. Третій — аудит та логування подій.

Практично завжди я ділю оточення на зони. Модель та дані живуть в ізольованій підмережі. Інтерфейси для користувачів — в іншій. Адмінські панелі — в третій. Так я зменшую ризики компрометації. Також я рекомендую налаштовувати рольову модель доступу. Потрібні ролі: адмін, оператор, користувач. Кожній ролі свої права.

| Напрямок | Що я роблю | Чому це важливо |

|---|---|---|

| Сегментація мережі | Ізолюю моделі від зовнішньої мережі | Менше точок входу для атак |

| Управління доступом | RBAC та окремі сервісні облікові записи | Мінімізація прав = менше ризиків |

| Логування та аудит | Зберігаю логи окремо та регулярно перевіряю | Дозволяє швидко виявити аномалії |

Нижче короткий список практик, які я застосовую негайно при розгортанні jan ai:

- Відключаю непотрібні сервіси та порти.

- Використовую окремі облікові записи для запуску сервісів.

- Включаю аудит доступу до моделей та до даних.

- Зберігаю резервні копії окремо та шифрую їх.

Конфіденційність — це не одна дія. Це набір дрібних рішень, які разом дають результат.

Шифрування, секрети та безпечне зберігання даних локально

Шифрування — моя перша лінія захисту для даних та ключів. Я завжди ставлю диск або том з моделями зашифрованим. Це допомагає, якщо обладнання вкрадуть або воно загубиться.

Для секретів я віддаю перевагу менеджеру ключів. Можна використовувати HashiCorp Vault, gpg або системні keyring. Ніколи не зберігаю ключі в коді. Якщо використовується docker, я пробрасую секрети через захищені змінні або секрети оркестратора.

| Елемент | Рекомендація |

|---|---|

| Диски та томи | Повне шифрування (LUKS/BitLocker) |

| Секрети | Менеджер секретів (Vault / gnome-keyring / pass) |

| Передача даних | TLS навіть всередині локальної мережі |

Я також налаштовую ротацію ключів та регулярну перевірку цілісності. Зберігаю резервні копії ключів в окремому фізичному сховищі. Якщо ви хочете просту опцію, шифруйте модельні файли та зберігайте ключ на USB в сейфі.

Тестування, відлагодження та типові проблеми при офлайн-роботі

Тестування офлайн-системи важливе. Я перевіряю не лише працездатність сервісу. Я прогоняю сценарії відмови. Симулюю втрату живлення. Відключаю мережу. Це виявляє помилки, які звичайне тестування пропустить.

Важливо розділяти тести на рівні. Юніт-тести для утиліт та завантажувачів. Інтеграційні — для API та потоків даних. Навантажувальні — для оцінки продуктивності. Моніторю метрики: затримки, використання пам’яті та CPU, помилки інференсу.

- Юніт-тести: перевіряю парсинг та обробку вхідних даних.

- Інтеграційні: перевіряю ланцюжок від запиту до відповіді моделі.

- Навантажувальні: імітую пікові сценарії та перевіряю деградацію.

Я використовую прості інструменти: curl для ручних перевірок, wrk або locust для навантаження, Prometheus + Grafana для моніторингу. Логи збираю централізовано. Це допомагає швидко знаходити причинно-наслідкові зв’язки.

Часті помилки при встановленні та їх рішення

За роки встановлення jan ai я помітив ряд повторюваних проблем. Я їх записав і тепер вирішую швидко.

| Проблема | Симптом | Рішення |

|---|---|---|

| Нестача пам’яті | Процеси падають при завантаженні моделі | Збільшити swap або використовувати квантовану модель |

| Несумісні драйвери GPU | Помилки при ініціалізації CUDA | Перевірити версії драйверів та бібліотеки CUDA/CuDNN |

| Проблеми з правами файлів | Доступ відмовлено при читанні моделі | Перевірити власника та права, використовувати безпечні сервісні облікові записи |

| Порт зайнятий | Сервіс не запускається: адреса вже використовується | Знайти процес та зупинити або змінити порт в конфігурації |

Ще кілька швидких порад, які я даю собі та колегам:

- Перевіряйте логи відразу. Вони часто говорять, що саме зламалося.

- Запускайте сервіс в інтерактивному режимі при відлагодженні.

- Робіть контрольні точки: якщо після оновлення щось зламалося, швидко відкотитися.

Відлагодження — це розмова з системою. Слухайте помилки, вони підкажуть шлях до виправлення.

Спільнота, оновлення та ресурси для розвитку навичок з jan ai

Я сам регулярно заходжу в спільноти навколо jan ai. Там швидко дізнаюся про нові релізи, патчі та інструкції. Важливо бути в курсі, тому що локальні проекти часто розвиваються через пул-реквести та сторонні утиліти. Я підписуюся на розсилки, читаю справи в трекерах та беру участь в обговореннях. Так простіше знаходити готові рішення та уникати типових помилок.

| Ресурс | Для чого | Частота оновлень |

|---|---|---|

| GitHub/репозиторії | Код, релізи, issue | в моменти релізів |

| Discord/Slack/Matrix | Швидкі питання та поради | постійно |

| Форуми та Reddit | Обговорення сценаріїв та кейсів | регулярно |

| Документація та вікі | Встановлення та приклади | по мірі оновлень |

Раджу зберігати закладки на кілька джерел та включати сповіщення про релізи. Я також тримаю локальну копію ключової документації. Це допомагає працювати офлайн та швидко вирішувати проблеми без інтернету.

Корисні інструменти, шаблони та репозиторії

Я використовую набір інструментів, який економить час при налаштуванні та експлуатації jan ai. Деякі речі реально спрощують життя. Нижче перелічу ті, що найчастіше застосовую.

- Інструменти для запуску: докер-контейнери, скрипти systemd, готові образи.

- Конвертери та рантайми: llama.cpp, ggml-формати, утиліти для перетворення з Hugging Face.

- Векторні сховища: FAISS, Chroma, Milvus для локальних векторних індексів.

- CLI та локальні API-обгортки, сумісні з OpenAI API, для уніфікованої інтеграції.

- Шаблони промптів та конфігурацій для персональних асистентів та чатів.

Нижче приклад, як виглядає проста структура репозиторію, яку я часто клоную та адаптую:

config/ run.sh docker-compose.yml models/ prompts/ docs/README.md

Якщо потрібно прискорити інференс, я беру готові скрипти квантування та тести продуктивності. Репозиторії з шаблонами зазвичай містять інструкції для Linux, macOS та Windows. Одного разу я налаштував шаблон під cron-завдання за годину, і він працював стабільно без інтернету.

Реальні кейси та готові сценарії використання jan ai без інтернету

Я люблю реальні приклади, тому що вони допомагають зрозуміти, де локальний ШІ дійсно корисний. Нижче мої улюблені сценарії, які вже перевірені в роботі та в хобі-проектах.

- Персональний офлайн-асистент для заміток, планування та пошукових запитів по локальних документах.

- Вбудована аналітика у виробництво для обробки журналів та попереджень без відправки даних в хмару.

- Медичні протоколи та довідкові системи в клініці, де важлива конфіденційність та доступ офлайн.

- Автономні квантифікатори та генерація звітів на IoT-пристроях з обмеженим з’єднанням.

- Локальна генерація контенту для сайтів та додатків, де потрібен повний контроль над даними.

| Сценарій | Користь | Необхідна інфраструктура |

|---|---|---|

| Офлайн-асистент для документів | Конфіденційність, швидкий пошук | Сервер 8+ GB RAM, векторний індекс |

| Виробничий моніторинг | Надійність, відсутність хмарної залежності | Локальні агенти, скрипти автоматизації |

| Медична довідка | Відповідність вимогам конфіденційності | Огороджена мережа, резервні копії |

Один з моїх проектів — офлайн-асистент для інженерів. Він відповідав на питання по кресленнях та документації прямо на заводі. Ніяких зовнішніх викликів. Результат: прискорення пошуку інформації та менше витоків даних.

Важливо тверезо оцінювати очікування. Локальні моделі не завжди замінять хмару за якістю генерації. Зате вони дають контроль, безпеку та передбачувану затримку.

Висновок: як прийняти рішення про перехід на jan ai офлайн

Я підходжу до рішення практично. Спочатку задаю ключові питання. Чи потрібна мені повна конфіденційність даних? Чи потрібна робота без інтернету? Який бюджет на обладнання та підтримку? Відповіді допомагають вибрати стратегію.

- Визначте вимоги: безпека, доступність, продуктивність.

- Оцініть ресурси: чи є сервери, навички з адміністрування, бюджет на моделі.

- Зробіть прототип: просте завдання, мінімальний стек, тести офлайн.

- Виміряйте метрики: латентність, якість відповідей, навантаження на залізо.

- Прийміть рішення: повний офлайн, гібрид або продовжувати в хмарі.

Я завжди раджу починати з прототипу. Так ви побачите реальні плюси та мінуси. Спільнота та готові репозиторії допоможуть скоротити час на впровадження. Якщо перед встановленням ви хочете ще раз звіритися з системними вимогами або подивитися альтернативи, загляньте в нашу картку Jan AI в каталозі нейромереж — там ми зібрали всі технічні характеристики в зручному форматі.